“Tenemos una responsabilidad histórica. Estamos en un momento en que podemos decidir qué tipo de humanidad queremos”. Son palabras mayúsculas, tanto como el reto que se plantea Rafael Yuste. A este neurocientífico español, catedrático de la Universidad de Columbia (EE UU), le susurran en la conciencia los fantasmas de otros grandes científicos de la historia que abrieron la caja de Pandora. Él, que ha impulsado la iniciativa Brain, la mayor apuesta por descubrir los secretos del cerebro, no elude su responsabilidad: “Lo llevo como un deber”. Yuste sabe bien lo que su campo, la neurotecnología, ya es capaz de ver y hacer en nuestras mentes. Y teme que se nos vaya de las manos si no se regula. Por eso reclama a los Gobiernos de todo el mundo que creen y protejan unos derechos de nuevo cuño: los neuroderechos. Chile quiere ser el primer país que los recoja en su carta magna y ya se está negociando para que este espíritu se incluya en la estrategia del Gobierno español para la inteligencia artificial.

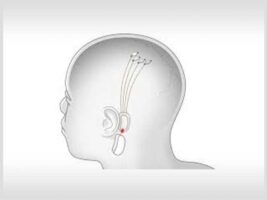

El año pasado, Yuste consiguió manipular el comportamiento de unos ratones. Y lo hizo interviniendo en los pequeños cerebros de estos roedores, amaestrados para sorber zumo cuando ven unas rayas verticales en una pantalla. Yuste y su equipo habían apuntado las neuronas concretas que se disparaban en ese momento y las estimularon directamente cuando en la pantalla no se veían las barras. Pero los ratones sorbieron zumo como si las hubieran visto. “Aquí en Columbia un colega mío ha desarrollado una prótesis visual inalámbrica para invidentes con un millón de electrodos, que permite conectar a una persona a la red. Pero también se puede usar para crear soldados con supercapacidades”, advierte Yuste. Ese aparato, financiado por Darpa (la agencia de investigación del Ejército de EE UU), podría estimular hasta 100.000 neuronas, aportando destrezas sobrehumanas.

“Estas grandes tecnológicas se están poniendo nerviosas para no quedarse atrás con el nuevo iPhone cerebral. Tenemos que acudir directamente a la sociedad y a quienes hacen las leyes para evitar abusos», afirma. La tecnología impulsada por Musk pretende ayudar a pacientes con parálisis o extremidades amputadas a controlar su expresión y movimiento o a ver y oír solo con el cerebro. Pero no oculta que el objetivo final es el de conectarnos directamente con las máquinas para mejorarnos con inteligencia artificial. La iniciativa de Facebook es similar: una empresa con el historial de respeto por la privacidad como la de Zuckerberg, accediendo a los pensamientos de sus usuarios.

Estas pretensiones parecen de ciencia ficción, pero un simple repaso por algunos logros de la neurociencia en los últimos tiempos ponen estas aspiraciones al alcance de la mano. En 2014 científicos españoles consiguieron transmitir «hola» directamente desde el cerebro de un sujeto al de otro, situado a 7.700 kilómetros de distancia, por medio de impulsos eléctricos. En varios laboratorios se ha conseguido recrear una imagen más o menos nítida de lo que un sujeto está viendo solo analizando las ondas cerebrales que produce. Gracias a la electroencefalografía se ha conseguido leer del cerebro palabras como «cuchara» o «teléfono» cuando alguien pensaba en ellas. También se ha usado para identificar estados de ánimo. En la Universidad de Berkeley fueron capaces de identificar la escena que estaban viendo los sujetos gracias a la nube de palabras que suscitaba su cerebro con el visionado: perro, cielo, mujer, hablar… Una tecnología que podría servir para descubrir sentimientos, dependiendo de las palabras que surjan al ver una imagen: por ejemplo, podría leer “odio” al visionar la imagen de un dictador.

Algunos de estos hitos tienen 10 años de antigüedad y desde entonces se han invertido miles de millones en monumentales proyectos privados y gubernamentales, desde Facebook a Darpa, pasando por la Academia de Ciencias de China. «Piensa que el proyecto chino es tres veces más grande que el estadounidense, y va directamente al grano, al fusionar las dos vertientes: inteligencia artificial y neurotecnología», advierte Yuste, que asegura ser optimista sobre las bondades de la neurotecnología y por eso quiere regularla.

“A corto plazo, el peligro más inminente es la pérdida de privacidad mental”, advierte Yuste, que lanzó su iniciativa por los neuroderechos tras debatirlo en Columbia con un equipo de veinticinco especialistas en neurociencia, derecho y ética denominado el Grupo Morningside. Numerosas compañías ya tienen desarrollados dispositivos, generalmente en forma de diadema, para registrar la actividad cerebral de los usuarios que quieran controlar mentalmente drones y coches, o medir el nivel de concentración o el estrés de los trabajadores, como sucede con conductores públicos en China. También allí se están usando con escolares: la diadema lee sus ondas cerebrales y una lucecita muestra al profesor su nivel de concentración. El problema es que la compañía que los vende, BrainCo, aspira a conseguir así la mayor base de datos de este tipo de actividad cerebral. Cuanto más datos tenga, mejores y más valiosas serán sus lecturas, lógicamente. Cuando la industria tecnológica lleva una década extrayendo todos los datos que puedan obtener del uso de aplicaciones y dispositivos, la posibilidad de exprimir cada neurona es un filón irresistible.

Diademas que espían neuronas

La regulación que plantea el grupo de Yuste tiene dos enfoques. Uno de autorregulación, con un juramento tecnocrático que obligue deontológicamente a ingenieros, informáticos y otros especialistas dedicados a la neurotecnología. En este sentido, se está negociando con España para llevar el espíritu de este juramento a la Estrategia Nacional de Inteligencia Artificial que prepara el Gobierno. Por otro lado, Yuste aspira a que los neuroderechos se recojan en la Declaración de Derechos Humanos y a que los Gobiernos establezcan un marco legal que evite los abusos. El pionero será Chile, con cuyo Gobierno tiene casi cerrada una legislación específica y su inclusión en la Constitución.

«Lo que me preocupa con más urgencia es el desciframiento de los neurodatos: la privacidad máxima de una persona es lo que piensa, pero ahora ya empieza a ser posible descifrarlo», avisa Yuste. «Lo estamos haciendo a diario en los laboratorios con ratones, en cuanto las compañías privadas tengan acceso a esta información, ríete tú de los problemas de privacidad que hemos tenido hasta ahora con los móviles. Por eso necesitamos neuroderechos, porque es un problema de derechos humanos», resume. El neurocientífico quiere alertar a la población porque «no hay nada de regulación y afecta a los derechos humanos básicos».

La neurobióloga Mara Dierssen, que no está implicada en la iniciativa de Yuste, destaca los problemas bioéticos derivados de las posibilidades de mejora del ser humano mediante neurotecnología. Aunque asegura que hay mucho sensacionalismo y arrogancia en torno a empresas como la de Musk, Dierssen resalta que «a largo plazo se pretende que los implantes puedan entrar en el campo de la cirugía electiva para quienes quieran ‘potenciar su cerebro con el poder de un ordenador». «¿Qué consecuencias puede tener la neuromejora en un mundo globalizado, biotecnificado y socioeconómicamente desigual? Inevitablemente surge la gran pregunta de en qué medida esas técnicas serían accesibles a todos», plantea Dierssen, investigadora del Centro de Regulación Genómica y expresidenta de la Sociedad Española de Neurociencia.

Para la neurocientífica Susana Martínez-Conde es una iniciativa «no solo positiva sino necesaria». «Nos estamos dando cuenta como sociedad de que los avances tecnológicos van mucho más allá de lo que estamos preparados filosófica y legalmente. Nos enfrentamos a situaciones sin experiencia previa en la historia», asegura Martínez-Conde, directora del laboratorio de Neurociencia Integrada de la Universidad del Estado de Nueva York. «Es necesario que tomemos nota porque la neurotecnología tiene repercusiones directas sobre lo que significa ser humano. Existe un potencial para el desastre si dejamos que se nos siga yendo de las manos porque hay una total falta de regulación. Es momento de actuar antes de un desastre a escala global», avisa.

Este desastre tiene resonancias históricas. Mientras conversa desde su despacho de Columbia, Yuste observa el edificio en el que se lanzó el proyecto Manhattan, que desembocó en el lanzamiento de sendas bombas atómicas sobre Hiroshima y Nagasaki. «Esos mismos científicos fueron luego los primeros en la línea de batalla para que se regulara la energía nuclear. La misma gente que hizo la bomba atómica. Nosotros estamos al lado, impulsando una revolución neurocientífica, pero también somos los primeros que tenemos que alertar a la sociedad», asegura.

NUEVOS ‘NEURODERECHOS’

El grupo impulsado por Rafael Yuste desarrolla sus preocupaciones en torno a cinco neuroderechos:

1.- Derecho a la identidad personal. Estos especialistas temen que al conectar los cerebros a computadoras se diluya la identidad de las personas. Cuando los algoritmos ayuden a tomar decisiones, el yo de los individuos puede difuminarse.

2.- Derecho al libre albedrío. Este neuroderecho está muy conectado con el de la identidad personal. Cuando contemos con herramientas externas que interfieran en nuestras decisiones, la capacidad humana para decidir su futuro puede verse en entredicho.

3.- Derecho a la privacidad mental. Las herramientas de neurotecnología que interactúen con los cerebros tendrán capacidad para recopilar todo tipo de información sobre los sujetos en el ámbito más privado que podamos imaginar: sus pensamientos. Los expertos consideran esencial preservar la inviolabilidad de los ‘neurodatos’ que generan los cerebros humanos.

4.- Derecho al acceso equitativo a las tecnologías de aumentación. Yuste cree que las neurotecnologías traerán innumerables beneficios para los humanos, pero teme que se multipliquen las desigualdades y privilegios de unos pocos, que accedan a estas nuevas capacidades humanas.

5.- Derecho a protección contra sesgos y discriminación. En los últimos años hemos conocido numerosos casos en los que los programas y algoritmos multiplican los prejuicios y sesgos. Este derecho pretende que esos fallos se busquen antes de ponerse en marcha.

Fuente: https://elpais.com/elpais/2020/01/30/ciencia/1580381695_084761.html